Roberto Cuesta Calvo - Mar, 18/11/2025 - 11:16

El uso de las deepkfakes: imágenes, vídeos o audios falsificados por la IA.

El uso de las deepkfakes: imágenes, vídeos o audios falsificados por la IA.

Serie: 'Seguridad a tu alcance' (CXIV)

En los últimos años, el avance de la inteligencia artificial, IA, ha permitido logros impresionantes en múltiples áreas. Sin embargo, junto con los beneficios también han surgido riesgos significativos, entre ellos uno de los más preocupantes: los deepfakes. Estas manipulaciones audiovisuales generadas mediante IA representan un desafío creciente para la confianza, la privacidad y la democracia.

¿Qué son?

El término deepfake proviene de la combinación de “deep learning” (aprendizaje profundo) y “fake” (falso). Se refiere a imágenes, videos o audios falsificados que utilizan redes neuronales para imitar de forma realista la voz, el rostro o los movimientos de una persona.

Hoy en día, con herramientas accesibles y gratuitas, es posible superponer rostros, clonar voces o crear escenas que nunca existieron, de forma tan convincente que resulta casi imposible distinguir la falsificación de la realidad.

Los peligros de los deepfakes

Los deepfakes suponen una amenaza no solo para la reputación individual, sino también para la seguridad pública, la justicia, la política y la economía.

Entre los riesgos más graves se encuentran:

- Desinformación y manipulación política: Se han difundido videos falsos en los que supuestamente líderes políticos hacen declaraciones incendiarias o confiesan actos que nunca cometieron. Aunque se desmientan, el daño a la opinión pública ya está hecho.

- Acoso, difamación y vulneración de la intimidad: Uno de los usos más alarmantes es la creación de contenido sexual falso:

- Imagina que alguien genera un video íntimo en el que aparece tu rostro, pero el cuerpo pertenece a otra persona. Aunque sea totalmente falso, el impacto emocional, social y profesional puede ser devastador.

- En muchos países, este tipo de manipulación ya se considera un delito de vulneración del derecho a la intimidad, suplantación de identidad o incluso pornografía no consentida.

- En España, por ejemplo, el artículo 197 del Código Penal castiga la difusión de imágenes o grabaciones de carácter íntimo sin consentimiento, incluso si fueron manipuladas o creadas artificialmente.

- Fraudes y suplantaciones: En el ámbito empresarial, ya se han reportado casos donde estafadores utilizaron voces generadas por IA para hacerse pasar por directivos y ordenar transferencias de dinero.

Este tipo de engaño combina ingeniería social y tecnología, dificultando su detección y aumentando las pérdidas económicas.

- Desconfianza generalizada: Cuando todo puede falsificarse —desde una declaración presidencial hasta un video de seguridad— la sociedad entra en una “crisis de verdad”. Cuestionar lo que vemos y oímos se convierte en la norma, debilitando la confianza en los medios y las instituciones.

¿Es delito crear un deepfake?

Depende del contexto y la intención, pero como norma general crear o compartir deepfakes dañinos puede implicar responsabilidad penal o civil, especialmente si vulneran derechos fundamentales como el honor, la privacidad o la propia imagen.

Si se realiza con fines humorísticos o artísticos, y sin dañar a nadie, puede considerarse lícito.

- Pero cuando un deepfake atenta contra la reputación, la intimidad o la seguridad de una persona, puede ser delito.

- En muchos países, ya se están tipificando expresamente desde un punto de vista penal la difusión de contenidos falsos con apariencia real que generen perjuicio o la creación de imágenes íntimas falsas sin consentimiento.

Cómo mitigar y combatir los deepfakes

Aunque eliminar completamente este fenómeno es difícil, existen estrategias tecnológicas, legales y educativas para reducir su impacto:

- Detección mediante IA: se desarrollan algoritmos capaces de detectar patrones artificiales, errores de sincronización o microexpresiones imposibles de replicar por completo. Esta detección será necesaria implementarla en casi todo…

- Regulación y legislación: nuevas leyes buscan castigar la creación o difusión de deepfakes dañinos, aunque en la actualidad existen normativa para enfrentar esto:

- 2.1 Código Penal español

Artículo 197 y siguientes – Protege la intimidad y la propia imagen, sancionando la obtención, uso o difusión de imágenes o grabaciones sin consentimiento, incluso manipuladas digitalmente.

Ejemplo: un deepfake sexual o íntimo difundido sin permiso podría considerarse delito contra la intimidad.

Artículo 401 – Sanciona la suplantación de identidad, aplicable cuando un deepfake se usa para hacerse pasar por otra persona.

Artículos 208–210 – Regulan injurias y calumnias, aplicables si el deepfake daña el honor o reputación de alguien.

Artículos 248 y 249 – Tipifican el fraude o la estafa, que puede incluir el uso de voces o rostros falsificados por IA para engañar o estafar.

En todos estos casos, los deepfakes se interpretan como un medio para cometer un delito existente, no como un delito independiente.

- 2.2. Ley Orgánica 3/2018 (LOPDGDD) y RGPD europeo

Ambas normas protegen los datos personales, incluidos los datos biométricos (como rostro o voz). Un deepfake que use tu imagen o voz sin consentimiento viola tu derecho a la protección de datos (artículos 4 y 9 del RGPD). Esto puede dar lugar a sanciones administrativas por parte de la Agencia Española de Protección de Datos (AEPD), además de acciones civiles o penales.

- 2.3. Ley Orgánica 1/1982 sobre el derecho al honor, intimidad y propia imagen

Esta ley te permite demandar civilmente a quien difunda un deepfake que atente contra tu dignidad, intimidad o reputación. Puedes solicitar:

- la retirada inmediata del contenido;

- indemnización por daños morales y materiales;

- y, en casos urgentes, medidas cautelares para frenar su difusión.

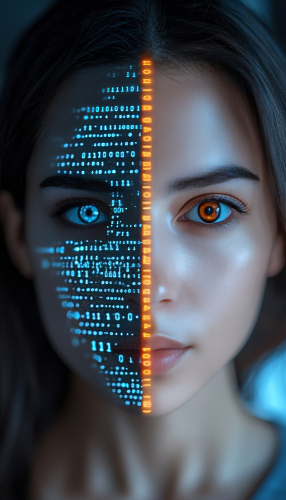

Símil de Inteligencia Artificial.

- 2.4. Marco europeo complementario

- AI Act (Reglamento de Inteligencia Artificial de la UE, aprobado en 2024): exige que los contenidos generados mediante IA, incluidos los deepfakes, deban identificarse claramente como tales. Entrará en vigor gradualmente entre 2025 y 2026.

- Digital Services Act (DSA): obliga a las plataformas digitales a retirar rápidamente contenidos falsos, manipulados o difamatorios cuando vulneren derechos fundamentales.

Estos instrumentos europeos reforzarán la protección en el entorno digital, especialmente frente a los usos maliciosos de la IA.

- Educación mediática: formar a la ciudadanía en pensamiento crítico, verificación de fuentes y análisis audiovisual es una herramienta clave contra la desinformación.

- Marcas digitales y autenticación: la implementación de marcas de agua invisibles, metadatos verificables y sistemas de origen certificado del contenido ayudará a identificar material auténtico frente a falsificaciones.

Hacia un uso ético de la inteligencia artificial

A pesar de sus riesgos, los deepfakes también pueden tener aplicaciones legítimas:

- En el cine, para rejuvenecer actores o recrear personajes históricos.

- En la educación, para traducir y doblar videos sin perder sincronía labial.

- En accesibilidad, para generar avatares que interpreten lenguaje de signos o voces personalizadas.

La clave está en establecer límites éticos y legales claros, asegurando que la innovación tecnológica no se convierta en un arma de manipulación o abuso.

Punto final

El fenómeno de los deepfakes ha pasado de ser un experimento tecnológico marginal a consolidarse como una de las amenazas digitales más significativas de la última década. En el ámbito del fraude, se estima que los casos relacionados con el uso de videos o audios generados mediante inteligencia artificial representan ya alrededor del 6,5 % de todos los intentos de estafa, lo que supone un incremento superior al 2.100 % en apenas tres años. Este crecimiento exponencial refleja el nivel de sofisticación y accesibilidad que han alcanzado las herramientas de generación sintética, capaces de producir falsificaciones cada vez más realistas. Según diversas fuentes, el contenido de vídeo y voz deepfake difundido en redes sociales superó los 500.000 archivos en 2023, una cifra que evidencia la rapidez con que este tipo de material se propaga y el desafío que representa para los mecanismos de verificación digital (artsmart.ai).

En un ámbito especialmente sensible, como el del contenido íntimo generado sin consentimiento, las cifras son igualmente preocupantes. Un estudio internacional publicado en arXiv reveló que aproximadamente el 2,2 % de las personas encuestadas se identificaron como víctimas de este tipo de manipulación, mientras que el 1,8 % admitió haber creado o difundido deepfakes de carácter sexual. Aunque estos porcentajes puedan parecer reducidos, evidencian una tendencia creciente que combina la vulneración de derechos fundamentales con un uso abusivo y deshumanizado de la tecnología. En el Reino Unido, otro estudio del mismo organismo indicó que el 8 % de los encuestados había utilizado herramientas de deepfake, mientras que el 90 % manifestó preocupación por sus implicaciones éticas, legales y sociales (arXiv, 2024). En conjunto, estos datos confirman que la exposición a contenidos sintéticos es cada vez más común, con estimaciones que sitúan en torno al 60 % la proporción de usuarios de internet que han visto alguna vez un deepfake.

El análisis de estas cifras demuestra que los deepfakes constituyen hoy una realidad consolidada con consecuencias directas sobre la seguridad, la confianza pública y la convivencia digital. El uso de tecnologías generativas para el fraude, la suplantación de identidad o el acoso personal se ha incrementado de forma alarmante, dejando claro que el riesgo ya no es hipotético, sino plenamente tangible. Si bien las víctimas de deepfakes íntimos representan una fracción menor en relación con la exposición general, las repercusiones sobre su reputación, bienestar emocional e incluso salud mental pueden ser devastadoras. A ello se suma una preocupación social creciente, acompañada de un desconocimiento generalizado sobre cómo detectar, denunciar o prevenir este tipo de manipulaciones.

Bibliografía

- Estella, A. (2025). La regulación de las deepfakes.

- Jiménez-Castellanos Ballesteros, I. (2025). La tecnología deepfake: La difícil convivencia entre la inteligencia artificial y los derechos fundamentales [Informe]. Universidad de Sevilla/Universidad CEU Fernando III.

- Cabrera, C. T. (2024). El derecho a la propia imagen (y a la voz) frente a la tecnología deepfake.

- “Deepfakes y el desafío de la autenticidad: Impacto sobre el honor, la intimidad y la imagen”. (2024). Revista de Derecho y Empresa, (número), páginas.

- ISMS Forum España. (2024). Deepfakes: Riesgos, casos reales y desafíos.

- Gobierno de España. (2025, 25 marzo). El Gobierno aprueba tipificar como delito los deepfakes de contenido sexual y el grooming.

- “1 de cada 5 jóvenes en España afirma haber sido víctima de deepfakes en la infancia o adolescencia, según informe”. (2025, 8 julio). Antena 3 Noticias.

- “Deepfakes y porno digital falso: el uso de la IA para atacar a mujeres políticas, activistas y periodistas”. (2025, marzo 8). Huffington Post España.

Legislación europea:

- Parlamento Europeo & Consejo de la Unión Europea. (2024). Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial y por el que se modifican los Reglamentos (CE) n.º 300/2008, (UE) n.º 167/2013, (UE) n.º 168/2013, (UE) 2018/858, (UE) 2018/1139 y (UE) 2019/2144 y las Directivas 2014/90/UE, (UE) 2016/797 y (UE) 2020/1828 (Reglamento de Inteligencia Artificial) (Texto pertinente a efectos del EEE).

Legislación española:

- Boletín Oficial del Estado. (1995). Código Penal (Ley Orgánica 10/1995, de 23 de noviembre).

- Boletín Oficial del Estado. (2018). Ley Orgánica de Protección de Datos Personales y Garantía de los Derechos Digitales (LO 3/2018).

- Boletín Oficial del Estado. (1982). Ley Orgánica de protección civil del derecho al honor, a la intimidad personal y familiar y a la propia imagen (LO 1/1982).

Editor: Universidad Isabel I

ISSN 2697-288X

Burgos, España